Was ist Retrieval-Augmented Generation (RAG)?

Retrieval-Augmented Generation (RAG) ist eine fortschrittliche KI-Technologie, die entwickelt wurde, um Informationen aus firmeninternen Wissensdatenbanken und Dokumenten abzurufen und so Lücken in großen Sprachmodellen (LLMs) zu schließen. Diese Technologie bereichert die Antworten eines Modells durch den Zugriff auf eine Vielzahl von Quellen und integriert präzise sowie aktuelle Fakten.

Die Integration von RAG in ein LLM bietet mehrere entscheidende Vorteile: RAG ermöglicht nicht nur den Zugriff auf die Quellen, die das Modell zur Generierung von Antworten herangezogen hat, sondern verweist auch explizit auf diese Quellen in den Antworten. Dies fördert die Transparenz und gibt den Nutzern die Möglichkeit, die Genauigkeit der Antworten zu überprüfen. Dadurch wird das Vertrauen in die von LLMs bereitgestellten Informationen gestärkt und die Zuverlässigkeit der generierten Inhalte erheblich erhöht.

In einer Zeit, in der Künstliche Intelligenz (KI) immer wichtiger wird, spielen große Sprachmodelle (LLMs) wie GPT-4 oder Llama eine zentrale Rolle. Diese Modelle haben die Verarbeitung natürlicher Sprache revolutioniert und ermöglichen es Unternehmen, komplexe Daten effizient zu analysieren und wertvolle Einblicke zu gewinnen. Trotz ihrer beeindruckenden Fähigkeiten stoßen diese Modelle jedoch bei der Verarbeitung großer Mengen an Kontextinformationen oft an ihre Grenzen, was zu ungenauen Ergebnissen führen kann. In diesem Kontext hat NVIDIA RankRAG entwickelt – ein bahnbrechendes Framework, das die Leistungsfähigkeit von LLMs auf ein neues Niveau hebt.

Was ist RankRAG?

RankRAG ist ein innovatives Framework, das ein einzelnes LLM so anleitet, dass es sowohl die Rangfolge von Kontexten bestimmen als auch Antworten generieren kann. Im Gegensatz zu traditionellen Retrieval-Augmented Generation (RAG)-Pipelines, die diese Aufgaben trennen, kombiniert RankRAG beide Schritte und liefert dadurch präzisere und effizientere Ergebnisse.

Wie funktioniert RankRAG?

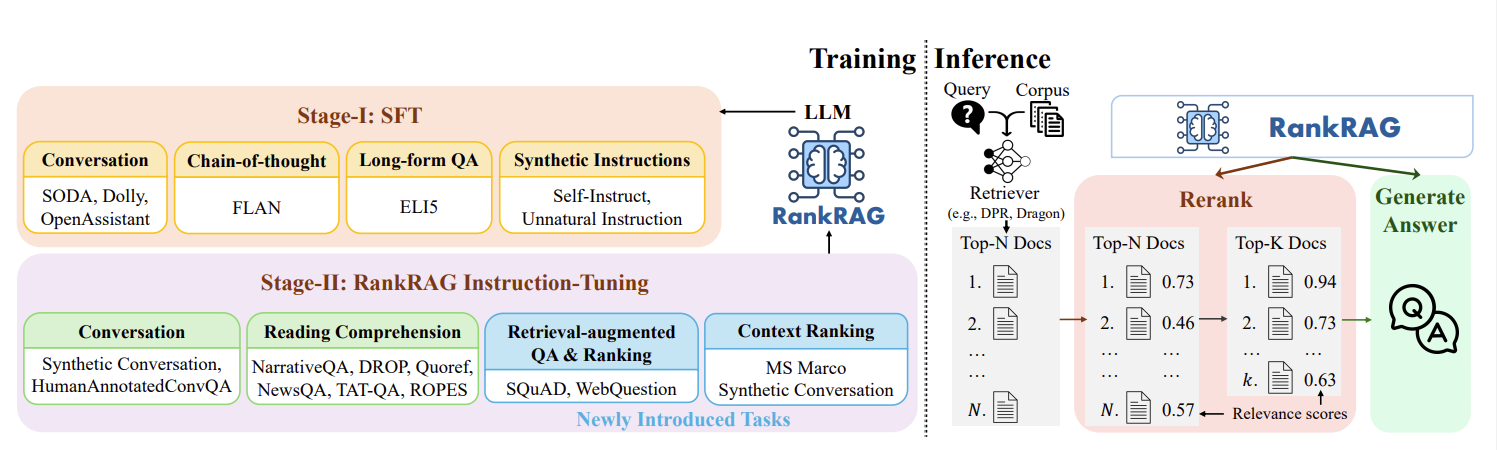

RankRAG basiert auf einem zweistufigen Trainingsprozess:

- Supervised Fine-Tuning (SFT): In dieser ersten Phase wird das LLM mithilfe hochwertiger Datensätze feingetunt, um sicherzustellen, dass es Anweisungen effektiv versteht und umsetzt.

- Vereinigtes Instruction-Tuning für Ranking und Generierung: In der zweiten Phase wird das LLM gleichzeitig darin geschult, Kontexte zu bewerten und Antworten zu generieren. Diese Phase nutzt hybride Datensätze, die kontextreiche Fragen-Antworten, retrieval-unterstützte Fragen-Antworten und Ranking-Daten kombinieren. Dadurch wird das LLM in die Lage versetzt, irrelevante Kontexte auszuschließen und sich auf die relevanten zu konzentrieren.

Der Arbeitsablauf von RankRAG lässt sich in drei Schritten zusammenfassen:

- Abrufen: Das Modell durchsucht einen Korpus und wählt die relevantesten Kontexte basierend auf einer gestellten Frage aus.

- Neusortieren: RankRAG sortiert die abgerufenen Kontexte neu und behält nur die wichtigsten bei.

- Generieren: Basierend auf den verfeinerten Kontexten generiert das LLM die finale Antwort.

Die Vorteile von RankRAG

Verbesserte Genauigkeit: Durch die Kombination von Kontext-Ranking und Antwortgenerierung erhöht RankRAG die Genauigkeit der generierten Antworten erheblich und übertrifft bestehende Modelle wie GPT-4 in verschiedenen Benchmarks.

Effizienz: Trotz des zusätzlichen Schritts des Neusortierens bleibt RankRAG effizient und erfordert nur minimalen zusätzlichen Datenaufwand oder Trainingszeit. Dies macht es zu einer praktischen Wahl zur Leistungssteigerung von LLMs.

Vielseitigkeit: Dank seines dualen Trainingsansatzes kann RankRAG in einer Vielzahl von Aufgaben und Bereichen eingesetzt werden. Es hat sich sowohl bei allgemeinen Anwendungen als auch im biomedizinischen Bereich als äußerst effektiv erwiesen, ohne dass zusätzliche domänenspezifische Feinabstimmungen erforderlich sind.

Experimentelle Ergebnisse

RankRAG wurde umfassend getestet und hat in verschiedenen Bereichen starke Baselines übertroffen:

- Open-Domain QA (OpenQA): In Datensätzen wie Natural Questions (NQ) und TriviaQA erzielte RankRAG beeindruckende Ergebnisse, die Llama3-ChatQA-1.5-70B übertrafen.

- Faktenüberprüfung: Im FEVER-Datensatz erreichte RankRAG eine höhere Genauigkeit als konkurrierende Modelle.

- Konversationelle QA (ConvQA): In Tests auf Datensätzen wie TopiOCQA erzielte RankRAG höhere F1-Werte als vergleichbare Modelle.

- Biomedizinischer Bereich: Selbst ohne weitere Anpassungen konnte RankRAG in biomedizinischen Benchmarks wie PubMedQA mit GPT-4 konkurrieren.

Fazit

RankRAG markiert einen entscheidenden Fortschritt in der Entwicklung großer Sprachmodelle und der augmentierten Generierung durch Retrieval. Durch die Feinabstimmung eines einzelnen LLMs zur gleichzeitigen Kontextbewertung und Antwortgenerierung überwindet RankRAG die Schwächen früherer RAG-Pipelines und liefert präzisere und schnellere Antworten. NVIDIA setzt mit RankRAG neue Maßstäbe für die Entwicklung und Nutzung von LLMs und ebnet den Weg für zukünftige Innovationen in der KI.

Häufig gestellte Fragen (FAQs)

1. Kann RankRAG in spezialisierten Bereichen eingesetzt werden?

Ja, RankRAG ist äußerst vielseitig und an verschiedene Domänen und Anwendungen anpassbar. Es hat sich bereits in allgemeinen sowie spezialisierten biomedizinischen Bereichen als effektiv erwiesen, ohne dass zusätzliche Feinabstimmungen erforderlich waren.

2. Auf welchen Benchmarks wurde RankRAG getestet?

RankRAG wurde auf neun allgemeinen und fünf spezialisierten biomedizinischen RAG-Benchmarks getestet. In allen Tests erzielte es bessere Ergebnisse als Llama3-ChatQA-1.5 und GPT-4.

3. Wie effizient ist RankRAG im Vergleich zu anderen Modellen?

Trotz eines zusätzlichen Neusortierungsschritts bleibt RankRAG sehr effizient. Es erfordert minimalen zusätzlichen Trainingsaufwand und ist daher eine praktische Lösung zur Verbesserung der LLM-Leistung.

4. Was unterscheidet RankRAG von traditionellen RAG-Pipelines?

Traditionelle RAG-Pipelines trennen in der Regel die Aufgaben der Kontextbewertung und Antwortgenerierung, was zu Ineffizienzen und Ungenauigkeiten führen kann. RankRAG vereint diese Aufgaben in einem einzigen LLM und erhöht so die Effizienz und Genauigkeit.

5. Wie stellt RankRAG sicher, dass relevante Inhalte korrekt wiedergegeben werden?

RankRAG verwendet einen Instruction-Tuning-Prozess, der kontextreiche Fragen-Antworten, retrieval-unterstützte Fragen-Antworten und Ranking-Datensätze umfasst. Dadurch wird die Fähigkeit des LLMs verbessert, irrelevante Kontexte auszuschließen und sicherzustellen, dass relevante Inhalte während der Retrieval- und Generierungsphasen korrekt wiedergegeben werden.

Wir bei Rocketta GmbH freuen uns, Ihnen diese fortschrittliche Technologie bald in unseren RAG-basierten KI-Lösungen zur Verfügung stellen zu können. Unsere Experten stehen bereit, um diese Innovation optimal in Ihrem Unternehmen zu implementieren und so die Effizienz und Genauigkeit Ihrer Datenverarbeitung zu maximieren. Kontaktieren Sie uns noch heute, um mehr zu erfahren!